Cronología del aprendizaje automático: Timeline of machine learning

Esta página es una cronología del aprendizaje automático . Se incluyen los principales descubrimientos, logros, hitos y otros eventos importantes.

Visión general

| Década | Resumen |

|---|---|

| <1950 | Los métodos estadísticos se descubren y perfeccionan. |

| 1950 | La investigación pionera en aprendizaje automático se lleva a cabo utilizando algoritmos simples. |

| 1960 | Se introducen métodos bayesianos para la inferencia probabilística en el aprendizaje automático. |

| 1970 | ' AI Winter ' causado por el pesimismo sobre la eficacia del aprendizaje automático. |

| Decenio de 1980 | El redescubrimiento de la retropropagación provoca un resurgimiento en la investigación del aprendizaje automático. |

| Decenio de 1990 | El trabajo en el aprendizaje automático cambia de un enfoque basado en el conocimiento a un enfoque basado en datos. Los científicos comienzan a crear programas para computadoras para analizar grandes cantidades de datos y sacar conclusiones, o "aprender", de los resultados. Las máquinas de vectores de soporte (SVM) y las redes neuronales recurrentes (RNN) se vuelven populares. Comenzaron los campos de la complejidad computacional a través de redes neuronales y la computación súper Turing. |

| 2000 | La agrupación en clústeres de vectores de soporte y otros métodos del kernel y los métodos de aprendizaje automático no supervisados se generalizan. |

| 2010 | El aprendizaje profundo se vuelve factible, lo que lleva a que el aprendizaje automático se convierta en parte integral de muchos servicios y aplicaciones de software ampliamente utilizados. |

Cronología

| Año | Tipo de evento | Subtítulo | Evento |

|---|---|---|---|

| 1763 | Descubrimiento | Los fundamentos del teorema de Bayes | Thomas Bayes trabajo 's Un ensayo hacia la solución de un problema en la Doctrina de Lo más probable es publicada dos años después de su muerte, habiendo sido modificado y editado por un amigo de Bayes, Richard Price . El ensayo presenta trabajos que sustentan el teorema de Bayes . |

| 1805 | Descubrimiento | Mínimos cuadrados | Adrien-Marie Legendre describe el "méthode des moindres carrés", conocido en inglés como el método de mínimos cuadrados . El método de mínimos cuadrados se utiliza ampliamente en el ajuste de datos . |

| 1812 | Teorema de Bayes | Pierre-Simon Laplace publica Théorie Analytique des Probabilités , en la que amplía la obra de Bayes y define lo que ahora se conoce como Teorema de Bayes . | |

| 1913 | Descubrimiento | Cadenas de Markov | Andrey Markov describe por primera vez las técnicas que utilizó para analizar un poema. Las técnicas más tarde se conocerán como cadenas de Markov . |

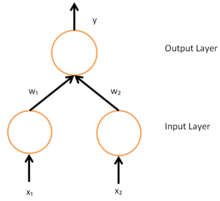

| 1943 | Descubrimiento | Neurona artificial | Warren McCulloch y Walter Pitts desarrollan un modelo matemático que imita el funcionamiento de una neurona biológica, la neurona artificial que se considera el primer modelo neuronal inventado. |

| 1950 | La máquina de aprendizaje de Turing | Alan Turing propone una 'máquina de aprendizaje' que podría aprender y volverse artificialmente inteligente. La propuesta específica de Turing presagia algoritmos genéticos . | |

| 1951 | Primera máquina de red neuronal | Marvin Minsky y Dean Edmonds construyen la primera máquina de red neuronal, capaz de aprender, la SNARC . | |

| 1952 | Máquinas jugando a las damas | Arthur Samuel se une al Laboratorio Poughkeepsie de IBM y comienza a trabajar en algunos de los primeros programas de aprendizaje automático, primero creando programas que juegan a las damas . | |

| 1957 | Descubrimiento | Perceptrón | Frank Rosenblatt inventa el perceptrón mientras trabajaba en el Laboratorio Aeronáutico de Cornell . La invención del perceptrón generó mucho entusiasmo y tuvo una amplia cobertura en los medios de comunicación. |

| 1963 | Logro | Máquinas que juegan Tic-Tac-Toe | Donald Michie crea una 'máquina' que consta de 304 cajas de fósforos y cuentas, que utiliza el aprendizaje por refuerzo para jugar Tic-tac-toe (también conocido como ceros y cruces). |

| 1967 | Vecino más cercano | Se creó el algoritmo de vecino más cercano , que es el comienzo del reconocimiento de patrones básico. El algoritmo se utilizó para mapear rutas. | |

| 1969 | Limitaciones de las redes neuronales | Marvin Minsky y Seymour Papert publican su libro Perceptrons , que describe algunas de las limitaciones de los perceptrons y las redes neuronales. La interpretación de que el libro muestra que las redes neuronales son fundamentalmente limitadas se considera un obstáculo para la investigación de las redes neuronales. | |

| 1970 | Diferenciación automática (retropropagación) | Seppo Linnainmaa publica el método general para la diferenciación automática (AD) de redes conectadas discretas de funciones diferenciables anidadas. Esto corresponde a la versión moderna de retropropagación, pero aún no se denomina como tal. | |

| 1979 | Carrito de Stanford | Los estudiantes de la Universidad de Stanford desarrollan un carro que puede navegar y evitar obstáculos en una habitación. | |

| 1979 | Descubrimiento | Neocognitron | Kunihiko Fukushima publica por primera vez su trabajo sobre el neocognitrón , un tipo de red neuronal artificial (ANN). La neocognición luego inspira redes neuronales convolucionales (CNN). |

| 1981 | Aprendizaje basado en explicaciones | Gerald Dejong presenta el aprendizaje basado en explicaciones, donde un algoritmo informático analiza datos y crea una regla general que puede seguir y descartar datos sin importancia. | |

| mil novecientos ochenta y dos | Descubrimiento | Red neuronal recurrente | John Hopfield populariza las redes Hopfield , un tipo de red neuronal recurrente que puede servir como sistemas de memoria direccionables por contenido . |

| 1985 | NetTalk | Terry Sejnowski desarrolla un programa que aprende a pronunciar palabras de la misma manera que lo hace un bebé. | |

| 1986 | Solicitud | Retropropagación | El modo inverso de diferenciación automática de Seppo Linnainmaa (aplicado por primera vez a las redes neuronales por Paul Werbos ) se utiliza en experimentos de David Rumelhart , Geoff Hinton y Ronald J. Williams para aprender las representaciones internas . |

| 1989 | Descubrimiento | Aprendizaje reforzado | Christopher Watkins desarrolla Q-learning , que mejora en gran medida la practicidad y viabilidad del aprendizaje por refuerzo . |

| 1989 | Comercialización | Comercialización de Machine Learning en Computadoras Personales | Axcelis, Inc. lanza Evolver , el primer paquete de software para comercializar el uso de algoritmos genéticos en computadoras personales. |

| 1992 | Logro | Máquinas jugando al backgammon | Gerald Tesauro desarrolla TD-Gammon , un programa de backgammon informático que utiliza una red neuronal artificial entrenada mediante el aprendizaje de diferencias temporales (de ahí el 'TD' en el nombre). TD-Gammon puede rivalizar, pero no superar constantemente, las habilidades de los mejores jugadores humanos de backgammon. |

| 1995 | Descubrimiento | Algoritmo de bosque aleatorio | Tin Kam Ho publica un artículo que describe los bosques de decisiones aleatorias . |

| 1995 | Descubrimiento | Máquinas de vectores de soporte | Corinna Cortes y Vladimir Vapnik publican su trabajo en máquinas de vectores de soporte . |

| 1997 | Logro | IBM Deep Blue vence a Kasparov | Deep Blue de IBM vence al campeón mundial de ajedrez. |

| 1997 | Descubrimiento | LSTM | Sepp Hochreiter y Jürgen Schmidhuber inventan redes neuronales recurrentes de memoria a corto plazo a largo plazo (LSTM), lo que mejora en gran medida la eficiencia y la practicidad de las redes neuronales recurrentes. |

| 1998 | Base de datos MNIST | Un equipo dirigido por Yann LeCun publica la base de datos MNIST , un conjunto de datos que comprende una combinación de dígitos escritos a mano de empleados de la Oficina del Censo de Estados Unidos y estudiantes de secundaria estadounidenses. Desde entonces, la base de datos MNIST se ha convertido en un punto de referencia para evaluar el reconocimiento de escritura a mano . | |

| 2002 | Biblioteca de aprendizaje automático de Torch | Se lanza por primera vez Torch , una biblioteca de software para el aprendizaje automático. | |

| 2006 | El premio Netflix | El Premio Netflix competencia es lanzado por Netflix . El objetivo de la competencia era utilizar el aprendizaje automático para superar la precisión del propio software de recomendación de Netflix al predecir la calificación de un usuario para una película dada su calificación de películas anteriores en al menos un 10%. El premio se ganó en 2009. | |

| 2009 | Logro | ImageNet | Se crea ImageNet . ImageNet es una gran base de datos visual imaginada por Fei-Fei Li de la Universidad de Stanford, quien se dio cuenta de que los mejores algoritmos de aprendizaje automático no funcionarían bien si los datos no reflejaran el mundo real. Para muchos, ImageNet fue el catalizador del boom de la IA del siglo XXI. |

| 2010 | Competencia Kaggle | Se lanza Kaggle , un sitio web que sirve como plataforma para competencias de aprendizaje automático. | |

| 2011 | Logro | Golpear a los humanos en peligro | Usando una combinación de aprendizaje automático, procesamiento de lenguaje natural y de información técnicas de recuperación, IBM 's Watson gana a dos campeones humanos en un peligro! competencia. |

| 2012 | Logro | Reconociendo gatos en YouTube | El equipo de Google Brain , dirigido por Andrew Ng y Jeff Dean , crea una red neuronal que aprende a reconocer gatos al ver imágenes sin etiquetas tomadas de fotogramas de videos de YouTube . |

| 2014 | Salto en el reconocimiento facial | Los investigadores de Facebook publican su trabajo en DeepFace , un sistema que utiliza redes neuronales que identifica caras con un 97,35% de precisión. Los resultados son una mejora de más del 27% con respecto a los sistemas anteriores y rivalizan con el desempeño humano. | |

| 2014 | Sibila | Los investigadores de Google detallan su trabajo en Sibyl, una plataforma patentada para el aprendizaje automático paralelo masivo que utiliza internamente Google para hacer predicciones sobre el comportamiento del usuario y proporcionar recomendaciones. | |

| 2016 | Logro | Vencer a los humanos en Go | El programa AlphaGo de Google se convierte en el primer programa Computer Go en vencer a un jugador humano profesional sin discapacidades utilizando una combinación de aprendizaje automático y técnicas de búsqueda de árboles. Posteriormente mejoró como AlphaGo Zero y luego en 2017 se generalizó a Ajedrez y más juegos de dos jugadores con AlphaZero . |

Ver también

- Historia de la inteligencia artificial

- Aprendizaje automático

- Cronología de la inteligencia artificial

- Cronología de la traducción automática